La inteligencia artificial esta transformando la forma en que trabajamos, nos comunicamos y tomamos decisiones. El ritmo de la innovacion trae consigo potencial para un cambio positivo, pero tambien riesgos si no se gestiona con prudencia.

Las decisiones que tomemos ahora sobre el desarrollo y la implementacion de la IA tendran consecuencias duraderas. Esta guia explora que significa la IA responsable, por que es importante y como las organizaciones pueden construir sistemas de IA que generen confianza.

Que significa la IA responsable?

La IA responsable va mas alla del rendimiento tecnico. Significa desarrollar sistemas con conciencia etica y responsabilidad: IA con conciencia.

La IA responsable crea sistemas que son transparentes en su funcionamiento, justos en su tratamiento y responsables de sus decisiones. Antes de implementar cualquier sistema de IA, pregunte: Quienes podrian verse afectados? Podria perjudicar a ciertos grupos? Podemos explicar sus conclusiones? Que sucede cuando se equivoca?

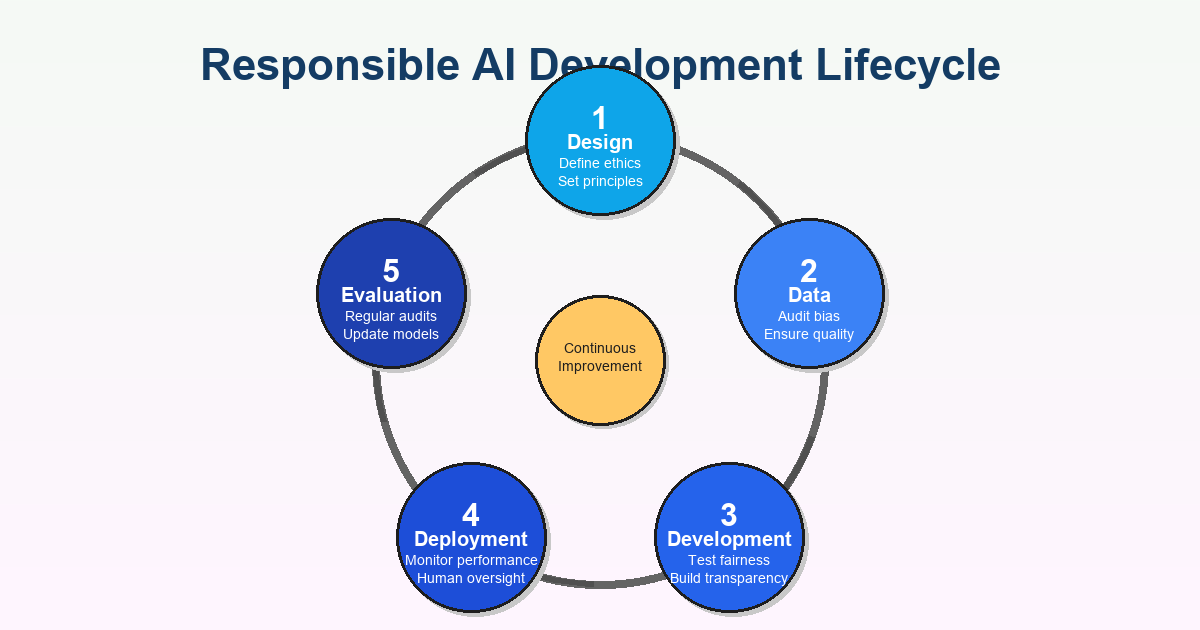

El objetivo no es la perfeccion. Es construir una IA que minimice el dano, respete los derechos humanos y se alinee con los valores de la sociedad a lo largo de todo el ciclo de vida, desde los datos de entrenamiento hasta el monitoreo posterior a la implementacion.

Por que deberian importarle a las organizaciones

Los sistemas de IA ahora toman decisiones que afectan la vida de las personas: quien es contratado, quien recibe prestamos, quien es puesto en libertad bajo fianza, que tratamientos medicos se recomiendan. Cuando estos sistemas funcionan bien, mejoran la eficiencia y la equidad. Cuando fallan, las consecuencias pueden ser devastadoras.

Considere el sesgo. La IA aprende de datos historicos, y si esos datos reflejan discriminacion pasada, la IA perpetua esos patrones. Hemos visto algoritmos de contratacion que favorecen a ciertos grupos demograficos, reconocimiento facial que funciona deficientemente con tonos de piel mas oscuros y modelos crediticios que perjudican a comunidades marginadas. Estos no son fallos tecnicos: son fracasos eticos que consolidan la desigualdad.

La transparencia es igualmente importante. Muchos sistemas de IA operan como cajas negras, tomando decisiones que sus creadores no pueden explicar completamente. Si una IA le niega a alguien un empleo o lo senala como de alto riesgo, esa persona merece entender por que. Sin transparencia, la responsabilidad desaparece y la confianza se erosiona.

La privacidad y la seguridad tambien son fundamentales. Los sistemas de IA requieren grandes cantidades de datos, que a menudo incluyen informacion personal sensible. Las organizaciones deben proteger estos datos y ser transparentes sobre su recopilacion y uso.

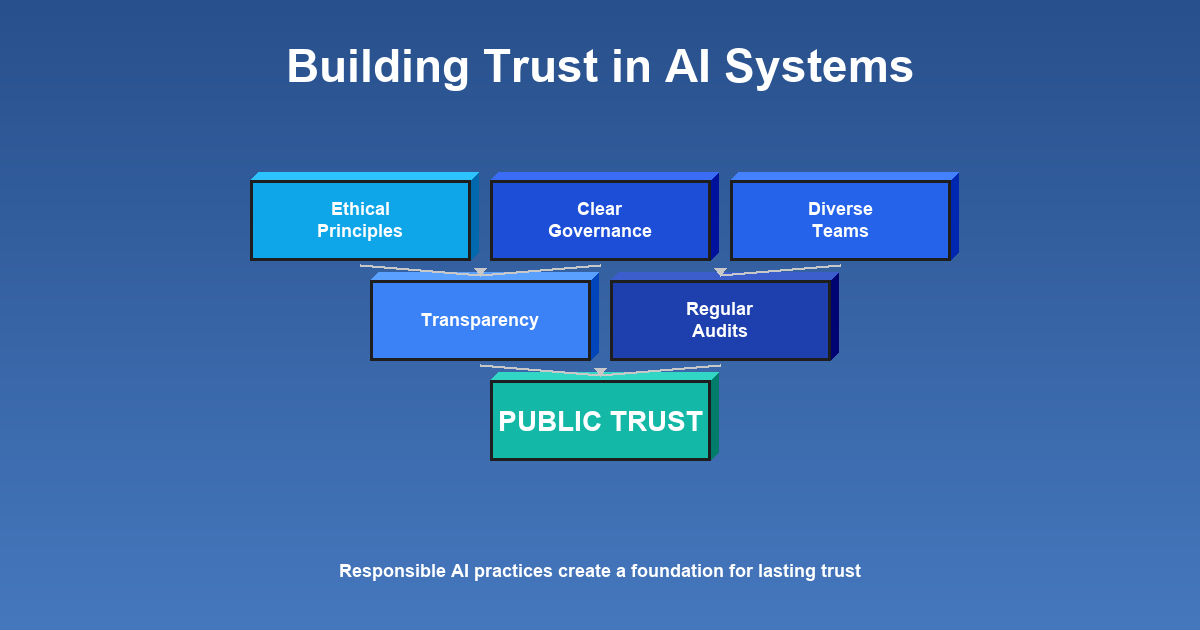

La confianza publica en la IA debe ganarse. Cuando las organizaciones toman atajos en practicas responsables, arriesgan su reputacion y la disposicion del publico a aceptar la IA en general. Construir confianza requiere una demostracion constante de que los sistemas sirven a los intereses de las personas.

El panorama regulatorio esta evolucionando rapidamente. Los gobiernos de todo el mundo estan introduciendo regulaciones de IA. Las organizaciones que no han priorizado la IA responsable podrian verse obligadas a cumplir apresuradamente. La responsabilidad proactiva es tanto eticamente solida como, cada vez mas, un requisito legal.

Construyendo IA responsable: un enfoque practico

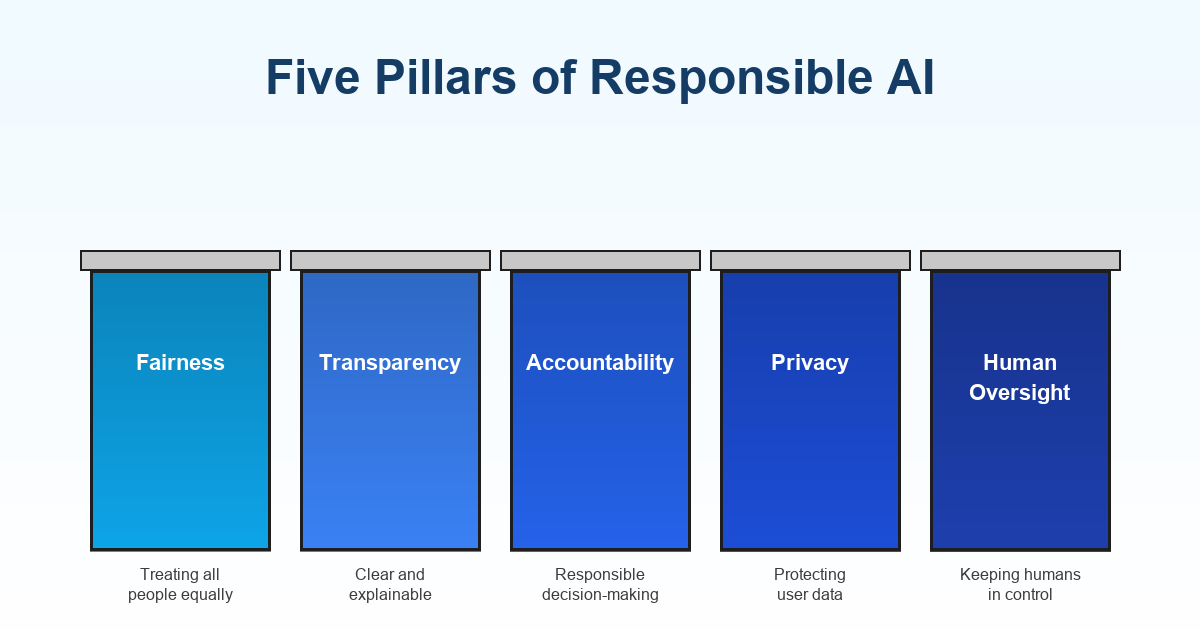

Comience con principios eticos claros que guien cada etapa del desarrollo y la implementacion. Estos deben ser especificos de su organizacion, pero generalmente incluyen compromisos con la equidad, la transparencia, la responsabilidad, la privacidad y la supervision humana.

Cree un marco de gobernanza que defina quien es responsable de las decisiones de IA, como se toman esas decisiones y que procesos existen para la revision y la auditoria. La gobernanza no debe ser una casilla de verificacion de cumplimiento: necesita integrarse en la cultura organizacional.

La diversidad en los equipos de desarrollo marca una diferencia real. Los equipos homogeneos tienen puntos ciegos sobre como los sistemas podrian afectar a diferentes comunidades. Los antecedentes y perspectivas variados ayudan a identificar problemas de manera temprana y a disenar soluciones que funcionen para todos.

Las auditorias regulares detectan problemas antes de que causen danos. Evaluen el sesgo, analicen el rendimiento entre grupos demograficos y monitoreen el impacto en el mundo real a lo largo del tiempo. Evaluar una sola vez en el lanzamiento no es suficiente: el monitoreo continuo es esencial porque los sistemas de IA pueden desviarse en produccion.

Priorice la transparencia desde el primer dia. Sea abierto sobre lo que hace un sistema de IA, que datos utiliza y como toma decisiones. Proporcione explicaciones para las decisiones impulsadas por IA, especialmente cuando afectan significativamente a las personas.

Invierta en educacion para asegurar que todos los involucrados (desarrolladores, ejecutivos, usuarios finales) comprendan tanto las capacidades como las limitaciones. La IA responsable requiere la aceptacion en todos los niveles.

Que sucede cuando las organizaciones se equivocan?

Una IA mal disenada perpetua y amplifica los sesgos existentes. Los algoritmos han discriminado a mujeres en la contratacion, han dado recomendaciones de sentencias mas severas para personas de color y han denegado servicios a poblaciones de edad avanzada. Estos no son riesgos hipoteticos: son fracasos documentados que perjudicaron a personas reales.

Cuando los fracasos se hacen publicos, el dano reputacional puede ser inmenso. La confianza, una vez perdida, es dificil de reconstruir. Los clientes, socios y empleados se vuelven escepticos del compromiso etico de la organizacion.

Las consecuencias legales son cada vez mas probables. Las organizaciones que implementan sistemas sesgados o daninos pueden enfrentar demandas, sanciones regulatorias y cambios obligatorios. Los reguladores estan asumiendo roles mas activos para responsabilizar a las organizaciones.

Mas alla de los danos directos, hay un costo social mas amplio. Cada fracaso de IA alimenta la ansiedad publica sobre estas tecnologias y dificulta que las organizaciones responsables implementen la IA de manera beneficiosa.

Las organizaciones que descuidan la IA responsable tambien pierden oportunidades de crear valor genuino. La IA bien hecha puede abordar los desafios mas urgentes de la sociedad, pero solo cuando se construye sobre la base de la confianza y la responsabilidad.

Lideres del mundo real en IA responsable

Muchas organizaciones estan dando ejemplos dignos de seguir. Microsoft desarrollo un marco integral de gobernanza de IA responsable con directrices detalladas y herramientas como listas de verificacion de equidad. Han puesto estos recursos a disposicion del publico, elevando el estandar en toda la industria.

IBM establecio una Junta de Etica de IA, un grupo dedicado que guia las iniciativas de IA y asegura la alineacion con los principios eticos. Esta estructura institucional senala que la IA responsable es una prioridad al mas alto nivel.

H&M desarrollo su propio marco de IA responsable para operaciones que van desde la gestion de inventario hasta el servicio al cliente, demostrando que la IA responsable no es solo para los gigantes tecnologicos.

Accenture implemento herramientas de contratacion impulsadas por IA disenadas para reducir el sesgo en el reclutamiento, con salvaguardas integradas y auditorias regulares. Esto muestra como los principios responsables pueden operacionalizarse donde los riesgos son altos.

Estos ejemplos comparten temas comunes: gobernanza proactiva, transparencia, monitoreo continuo y disposicion a rendir cuentas.

Avanzando

La IA responsable es un viaje, no un destino. A medida que las tecnologias evolucionan, nuestra comprension de la responsabilidad tambien se desarrollara. Lo que importa es el compromiso de cuestionar, mejorar y responsabilizarnos continuamente.

Esto no es solo un imperativo etico, es estrategico. Las organizaciones que construyen confianza a traves de practicas responsables estaran mejor posicionadas para innovar, atraer talento, cumplir con las regulaciones y construir relaciones duraderas.

El potencial de la IA es real, pero realizarlo requiere intencionalidad. Al adoptar practicas responsables, las organizaciones ayudan a garantizar que, a medida que la IA se vuelve mas poderosa, refleje nuestros valores mas elevados.

La pregunta no es si tendremos IA, ya la tenemos. La pregunta es de que tipo: IA que refuerza las desigualdades o promueve la equidad; IA que opera en las sombras o es transparente; IA que sirve a intereses limitados o beneficia a la sociedad. Estas decisiones son nuestras.