Sus empleados ya están usando IA. La pregunta es si usted lo sabe.

Un desarrollador pega código fuente propietario en ChatGPT. Un analista de marketing sube datos de clientes a una herramienta de generación de imágenes. Un miembro del equipo de finanzas enruta consultas sensibles a través de un endpoint LLM no aprobado. Ninguna de estas interacciones aparece en ningún registro de software aprobado.

Esto es shadow AI: el uso de herramientas de IA dentro de una organización sin aprobación de TI, seguridad o cumplimiento. No aparece en los inventarios de software sino en los registros de red. Y la brecha entre la adopción y la gobernanza sigue ampliándose. Para cuando una organización descubre una herramienta no aprobada, es posible que los datos sensibles ya se hayan enviado a un proveedor con políticas de retención y entrenamiento desconocidas.

Las consecuencias son concretas. Los datos enviados a proveedores de IA pueden ser retenidos, usados para entrenamiento o expuestos a través de brechas de seguridad. Esto crea exposición de cumplimiento bajo el GDPR, HIPAA, SOC 2 y reglas sectoriales específicas que requieren controles de procesamiento de datos. Las relaciones con proveedores no se rastrean: sin acuerdos de procesamiento de datos, sin evaluaciones de seguridad, sin protecciones contractuales.

Y cuando un regulador pregunta qué herramientas de IA usa la organización, quién las usa y qué datos procesan, la mayoría de las organizaciones no pueden responder.

Por qué las herramientas de seguridad tradicionales se quedan cortas

Los firewalls pueden bloquear dominios pero no pueden categorizar el tráfico como relacionado con IA ni evaluar el perfil de riesgo de un proveedor de IA. Los sistemas DLP detectan patrones en datos salientes pero no mantienen un registro de herramientas de IA. Las plataformas SIEM recopilan los registros sin procesar que contienen evidencia del uso de IA pero carecen de la lógica de detección para encontrarlo y clasificarlo.

Lo que se necesita es un sistema que ingiera datos de registro existentes, identifique el uso de herramientas de IA, puntúe el riesgo y proporcione un camino desde la detección hasta la gobernanza.

Cómo funciona la detección de Shadow AI de VerifyWise

La detección de Shadow AI en VerifyWise es pasiva. Sin agentes en endpoints, sin extensiones de navegador. Ingiere datos de registro que las organizaciones ya recopilan de su infraestructura de seguridad.

Ingesta de registros

Están disponibles dos métodos de ingesta. Una API REST acepta eventos en formato JSON y funciona con sistemas SIEM, pipelines de registros personalizados y herramientas de orquestación. Un receptor syslog en el puerto TCP 5514 acepta mensajes syslog estándar de proxies web, firewalls y dispositivos de red.

Análisis y normalización

Los registros sin procesar llegan en diferentes formatos dependiendo de la fuente. Cuatro analizadores integrados manejan las fuentes empresariales más comunes: Zscaler Internet Access, Netskope Cloud Security, proxy Squid y un analizador genérico de clave-valor para sistemas que producen pares estructurados de clave=valor. Cada analizador extrae marca de tiempo, IP de origen, nombre de usuario, dominio de destino, ruta URL, método HTTP, bytes transferidos y acción tomada, luego los normaliza en un esquema de eventos común.

Identificación de herramientas de IA

Los eventos normalizados se comparan con un registro curado de más de 50 herramientas y servicios de IA organizados por categoría: chatbots LLM (ChatGPT, Claude, Gemini, Perplexity), asistentes de codificación (GitHub Copilot, Cursor, Tabnine), generadores de imágenes (Midjourney, DALL-E, Stable Diffusion), herramientas de escritura (Notion AI, Jasper, Grammarly) y plataformas de IA low-code (v0.dev, Bolt, Replit). Cada entrada del registro incluye el nombre de la herramienta, proveedor, dominios asociados, clasificación de riesgo predeterminada y metadatos de categoría.

La detección va más allá de la coincidencia de dominios. Los patrones regex aplicados a las rutas URI extraen identificadores de modelos específicos del tráfico de API. Cuando una solicitud llega al endpoint de AWS Bedrock con una ruta que contiene anthropic.claude-3-opus, o cuando el tráfico a Azure OpenAI referencia gpt-4-turbo en la ruta de despliegue, el sistema captura el modelo específico que se está invocando. Esta extracción a nivel de modelo cubre AWS Bedrock, Azure OpenAI, Google Vertex AI y endpoints de API directos de los principales proveedores.

Enriquecimiento de eventos

Cada evento detectado se enriquece con contexto organizacional. El nombre de usuario se correlaciona con departamento, título del puesto y gerente directo a partir de los datos del SIEM. Esto importa para la puntuación de riesgos: un analista de finanzas accediendo a una herramienta de IA no aprobada conlleva un riesgo diferente al de un desarrollador usando la misma herramienta.

Puntuación de riesgos: cuatro factores ponderados

Cada herramienta de IA detectada obtiene una puntuación de riesgo compuesta de 0 a 100, calculada a partir de cuatro factores ponderados.

Estado de aprobación (40%) es el factor más importante. Una herramienta no aprobada sin registro de gobernanza recibe la penalización máxima. Una herramienta formalmente revisada y aprobada recibe el mínimo. Las herramientas en revisión activa quedan en el medio.

Cumplimiento de la política de datos (25%) evalúa la postura de seguridad del proveedor de IA. ¿El proveedor tiene SOC 2 Tipo II? ¿El servicio cumple con el GDPR con un acuerdo de procesamiento de datos publicado? ¿El proveedor cifra los datos en reposo y en tránsito? ¿Usa datos de clientes para el entrenamiento del modelo? Los proveedores con políticas de entrenamiento opt-out o sin política de retención publicada obtienen un riesgo más alto.

Sensibilidad del departamento (20%) pondera más alto el uso desde Finanzas, Legal, RRHH y funciones Ejecutivas que desde Marketing, Ventas o Ingeniería. Estos departamentos manejan datos regulados (registros financieros, privilegio legal, PII de empleados, planes estratégicos) donde la exposición a una herramienta de IA no evaluada tiene consecuencias desproporcionadas.

Volumen de uso (15%) normaliza los recuentos de eventos sin procesar contra los promedios organizacionales para encontrar valores atípicos. Una herramienta que genera 10x el volumen promedio de tráfico es de riesgo elevado independientemente del estado de aprobación, porque un alto volumen implica una integración más profunda en el flujo de trabajo y una mayor exposición de datos.

Las puntuaciones de riesgo no son estáticas. Se recalculan a medida que llegan nuevos eventos, cambian los patrones de uso y el estado de la herramienta progresa a través de la gobernanza.

Alertas a través de un motor de reglas configurable

El sistema de alertas tiene seis tipos de disparadores configurables:

- Nueva herramienta de IA detectada - se activa cuando el sistema ve una herramienta que nunca ha encontrado en el tráfico de la organización

- Umbral de uso excedido - se activa cuando el recuento de eventos de una herramienta supera un límite configurable dentro de un período de tiempo

- Acceso de departamento sensible - se activa cuando usuarios de departamentos de alta sensibilidad acceden a una herramienta o categoría de herramientas

- Intentos de acceso bloqueados - se activa cuando los registros muestran que un proxy o firewall bloqueó el acceso a una herramienta de IA, indicando intención incluso cuando se denegó el acceso

- Puntuación de riesgo excedida - se activa cuando la puntuación de riesgo compuesta de una herramienta cruza un límite configurable

- Nuevo usuario detectado - se activa cuando un usuario previamente no visto comienza a acceder a una herramienta de IA conocida

Cada regla puede disparar una o más acciones: enviar notificaciones de alerta, crear tareas de gobernanza con propietarios y plazos, iniciar una revisión de gobernanza o crear entradas de riesgo. Los períodos de enfriamiento previenen la fatiga de alertas al suprimir notificaciones repetidas durante un intervalo configurable. Las listas de destinatarios se configuran por regla, de modo que una alerta de nueva herramienta llega al equipo de seguridad mientras una alerta de departamento sensible va al oficial de cumplimiento.

De la detección a la gobernanza en cuatro pasos

La mayoría de las organizaciones que abordan la shadow AI se detienen en la detección. Identifican qué herramientas están en uso, producen un informe y dejan el resto a procesos manuales para decidir qué sucede después. VerifyWise cierra esa brecha con un asistente de gobernanza que convierte una herramienta detectada en un activo gestionado y rastreable.

-

Paso 1: Agregar al inventario de modelos. La herramienta detectada se agrega al inventario de modelos de la organización. Los campos se rellenan previamente con datos de detección: nombre de la herramienta, proveedor, dominio principal, categoría, puntuación de riesgo inicial. El propietario de gobernanza revisa y complementa esta información.

-

Paso 2: Asignar propiedad de gobernanza. Se asigna un propietario, un revisor y una fecha límite. El propietario impulsa la evaluación; el revisor proporciona supervisión secundaria; la fecha límite crea responsabilidad.

-

Paso 3: Evaluación de riesgos. Una evaluación estructurada captura la clasificación de sensibilidad de datos (qué tipos de datos están expuestos), recuento de usuarios (cuántas personas lo usan) y exposición departamental (qué funciones están afectadas). Esto alimenta el registro de riesgos de VerifyWise.

-

Paso 4: Iniciar el ciclo de vida del modelo (opcional). La herramienta puede inscribirse en un proceso de ciclo de vida completo, activando la revisión de seguridad del proveedor, revisión legal de los términos de servicio y negociación del acuerdo de procesamiento de datos.

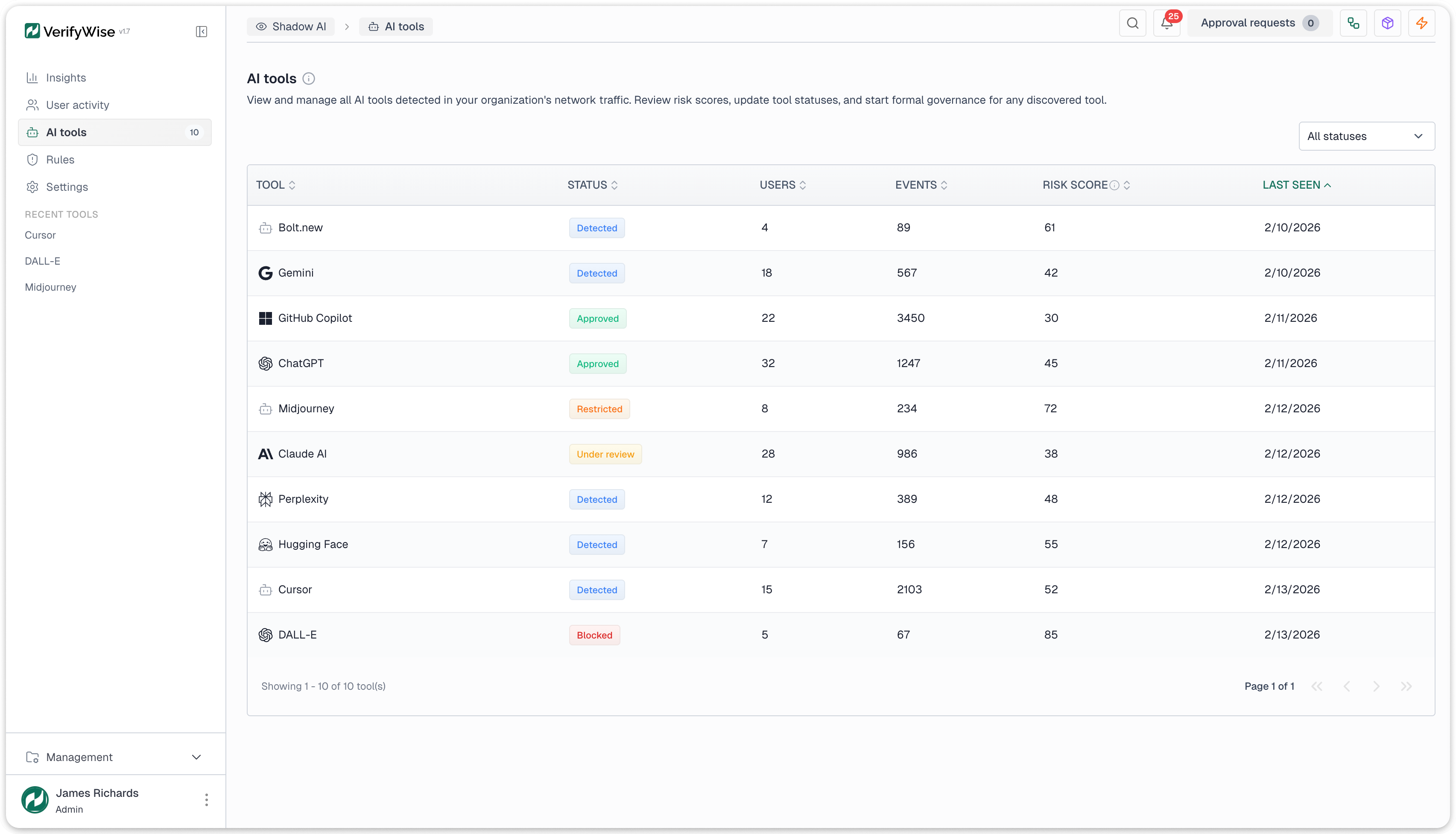

A medida que una herramienta avanza a través de la gobernanza, su estado progresa: Detectada (sin acción tomada), En revisión (gobernanza iniciada), luego uno de cuatro estados finales: Aprobada (sancionada), Restringida (permitida con condiciones), Bloqueada (prohibida) o Descartada (irrelevante o falso positivo).

Esto produce una cadena auditable desde "herramienta desconocida en tráfico de red" a través de "revisión de gobernanza con propietario asignado" hasta "activo de IA formalmente gobernado con decisión de aprobación documentada". Esa cadena es lo que los reguladores y auditores buscan.

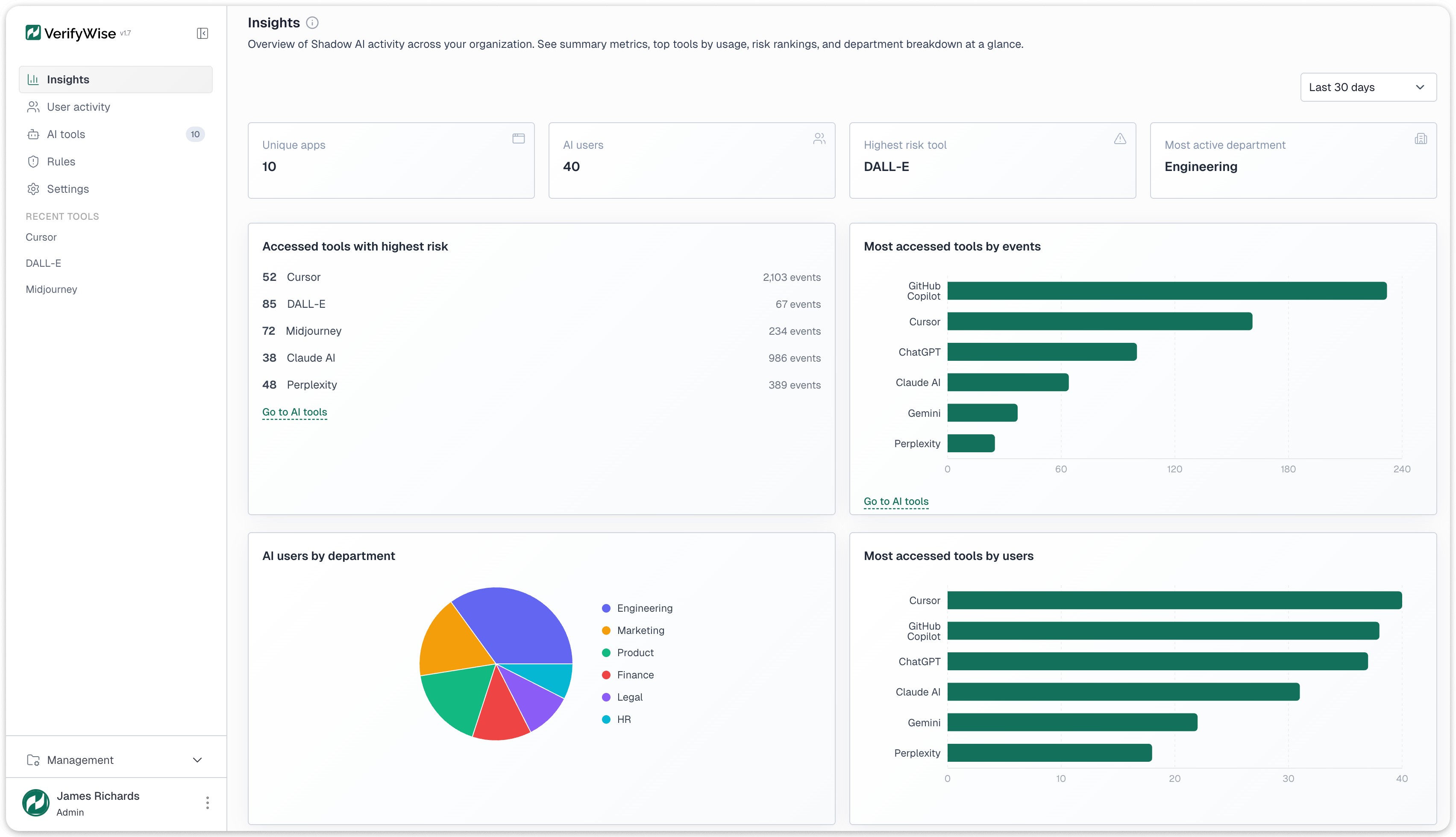

Analítica e informes

El panel de información se abre con cuatro tarjetas KPI: aplicaciones de IA únicas descubiertas, total de usuarios de IA en todas las herramientas, la herramienta de mayor riesgo actualmente detectada y el departamento más activo por volumen de eventos. Estas proporcionan una instantánea de nivel ejecutivo antes de cualquier profundización.

Cuatro tipos de gráficos proporcionan vistas más profundas. Un gráfico de barras de herramientas por volumen de eventos clasifica las herramientas detectadas por tráfico total, mostrando qué herramientas tienen la mayor superficie de exposición de datos. Un gráfico de barras de herramientas por usuarios únicos clasifica por recuento de usuarios distintos, revelando qué herramientas tienen la adopción más amplia. Un gráfico circular de usuarios por departamento muestra dónde se concentra el uso de IA. Un gráfico de líneas de análisis de tendencias rastrea el total de eventos, usuarios únicos y nuevos descubrimientos de herramientas en rangos configurables de 30 días a un año.

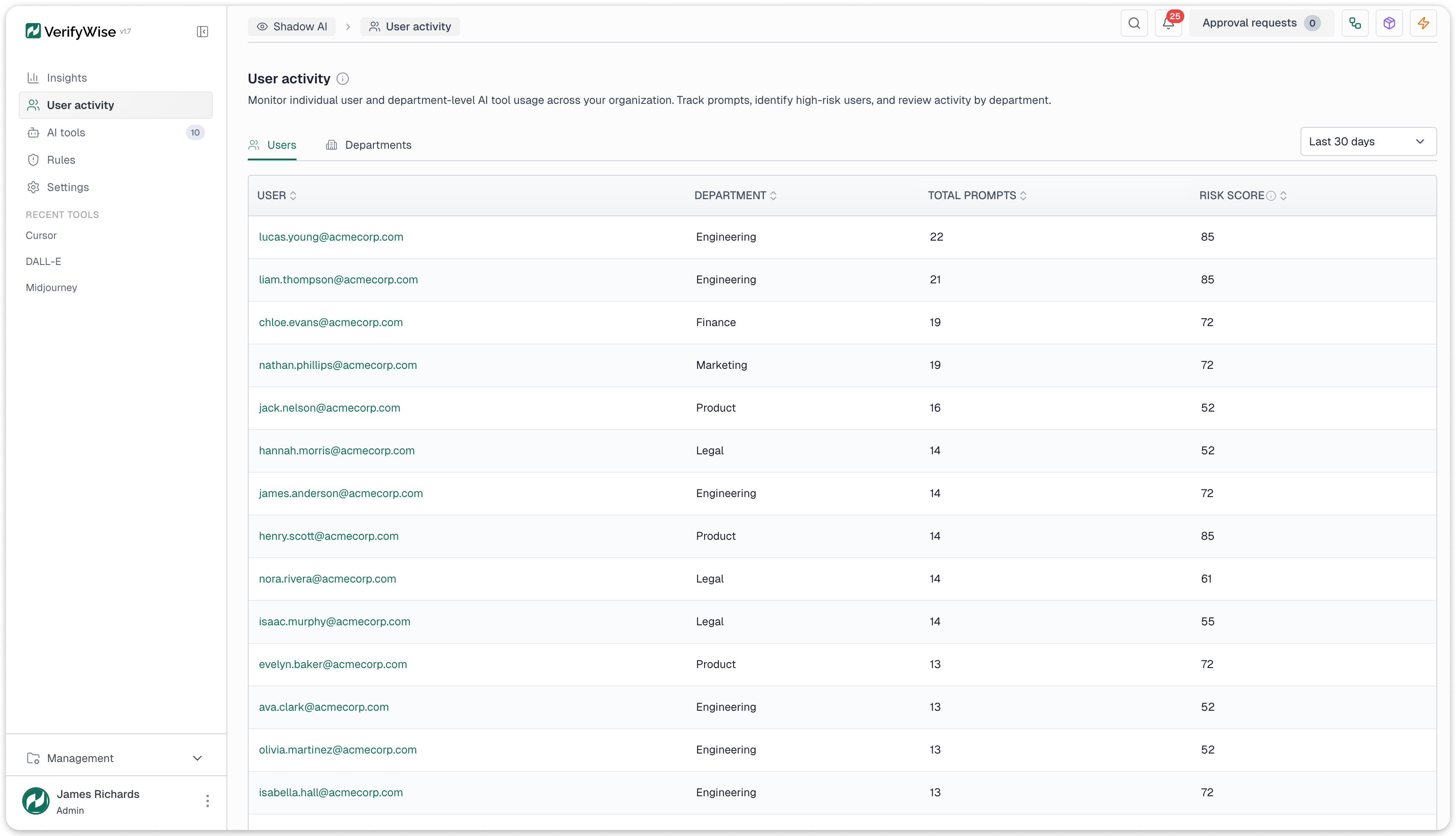

Los datos de actividad de usuarios están disponibles en dos niveles. A nivel individual: recuentos de eventos de cada usuario, herramientas accedidas, puntuaciones de riesgo y departamento. A nivel departamental: uso agregado, principales herramientas y exposición máxima al riesgo, adecuado para informes a jefes de departamento y comités de cumplimiento.

Retención de datos

Un modelo de retención de tres niveles equilibra la profundidad con el almacenamiento:

- Eventos sin procesar se conservan durante 30 días con detalle completo para investigación forense y profundización

- Resúmenes diarios se conservan durante un año, proporcionando resúmenes agregados para análisis de tendencias e informes trimestrales

- Resúmenes mensuales se conservan permanentemente para comparaciones interanuales y consultas regulatorias que abarcan múltiples años

Todos los datos son buscables, clasificables y filtrables. Las exportaciones están disponibles para flujos de trabajo de cumplimiento que requieran extracción de datos para auditores o presentaciones regulatorias.

Lo que la detección de Shadow AI puede y no puede hacer

Es importante ser claro sobre el alcance. La detección de Shadow AI opera sobre metadatos de red. Esto es lo que cubre y dónde tiene limitaciones.

Lo que hace:

- Descubre el uso de herramientas de IA en la nube y SaaS a partir de registros de red sin agentes en endpoints ni extensiones de navegador

- Identifica más de 50 herramientas de IA en cinco categorías y extrae nombres de modelos específicos del tráfico de API en AWS Bedrock, Azure OpenAI, Google Vertex AI y endpoints directos de proveedores

- Puntúa el riesgo en una escala de 0 a 100 usando cuatro factores ponderados: estado de aprobación, postura de cumplimiento del proveedor, volumen de uso y sensibilidad del departamento

- Alerta a los equipos a través de 6 tipos de disparadores con 4 tipos de acciones (notificaciones, tareas, revisiones de gobernanza, entradas de riesgo)

- Convierte herramientas detectadas en activos gobernados a través de un asistente de cuatro pasos que crea entradas en el inventario de modelos, asigna propietarios e inicia evaluaciones de riesgos

- Analiza 4 formatos de registro de forma nativa (Zscaler, Netskope, Squid, clave-valor genérico)

Lo que no hace:

- Inspeccionar contenido HTTPS cifrado. Opera sobre metadatos: dominios, rutas URL, marcas de tiempo, identificadores de usuario. Extraer esto del tráfico cifrado requiere un proxy de intercepción TLS o gateway de API aguas arriba

- Detectar modelos de IA alojados localmente (Ollama, instancias locales de Llama, servidores de inferencia privados). Estos no generan tráfico de red externo

- Capturar prompts, respuestas o conversaciones reales. Trabaja solo con metadatos de acceso: quién accedió a qué, cuándo, desde qué departamento, con qué frecuencia

- Bloquear tráfico. Es solo consultivo. Bloquear el acceso requiere configuración en la capa de proxy, firewall o DNS

- Ejecutar detección de anomalías de comportamiento. Las alertas son basadas en reglas con umbrales explícitos, no análisis de patrones impulsado por ML

Primeros pasos

La detección de Shadow AI es un módulo dentro de la plataforma de gobernanza de IA VerifyWise, junto con inventario de modelos, gestión de riesgos, seguimiento de marcos de cumplimiento y evaluaciones de LLM. Si su organización ya está recopilando registros de proxy web o firewall, tiene los datos que necesita. La pregunta es si los está usando para encontrar herramientas de IA antes de que se conviertan en incidentes de cumplimiento.

Explore nuestra función de Detección de Shadow AI para ver cómo el descubrimiento pasivo basado en registros, la puntuación de riesgos y los flujos de trabajo de gobernanza se unen en una sola plataforma.

Reserve una demostración para ver cómo funciona la detección de Shadow AI con su infraestructura de registros existente, o explore la plataforma VerifyWise completa para ver cómo la detección se conecta con la gobernanza.