L'intelligence artificielle transforme notre facon de travailler, de communiquer et de prendre des decisions. Le rythme de l'innovation offre un potentiel de changement positif, mais aussi des risques si elle n'est pas geree de maniere reflechie.

Les choix que nous faisons aujourd'hui concernant le developpement et le deploiement de l'IA auront des consequences durables. Ce guide explore ce que signifie l'IA responsable, pourquoi elle est importante et comment les organisations peuvent construire des systemes d'IA qui inspirent confiance.

Que signifie l'IA responsable ?

L'IA responsable va au-dela de la performance technique. Elle signifie developper des systemes avec une conscience ethique et une responsabilite — une IA dotee d'une conscience.

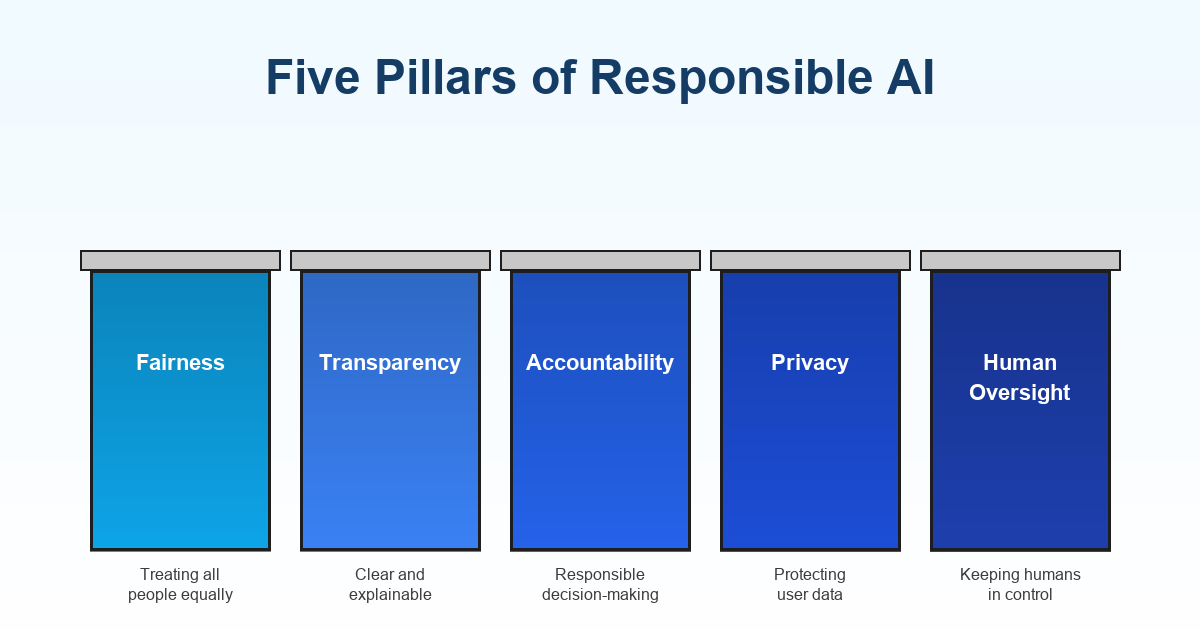

L'IA responsable cree des systemes transparents dans leur fonctionnement, equitables dans leur traitement et responsables de leurs decisions. Avant de deployer tout systeme d'IA, posez-vous ces questions : qui pourrait etre affecte ? Pourrait-il desavantager certains groupes ? Pouvons-nous expliquer ses conclusions ? Que se passe-t-il lorsqu'il se trompe ?

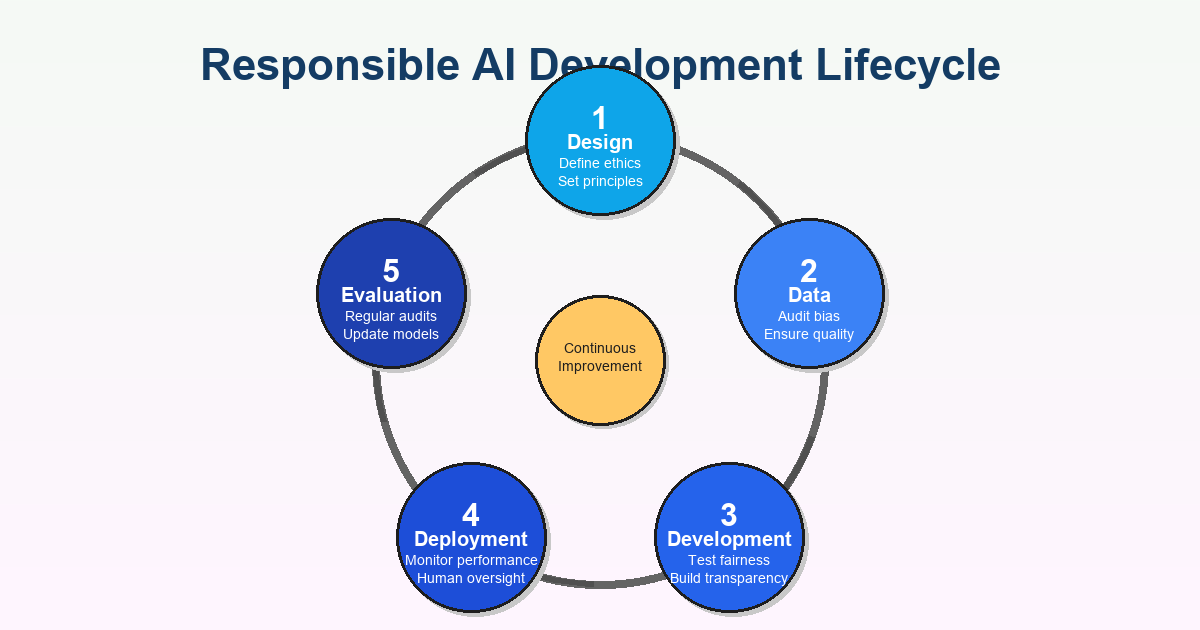

L'objectif n'est pas la perfection. Il s'agit de construire une IA qui minimise les prejudices, respecte les droits humains et s'aligne sur les valeurs societales tout au long du cycle de vie — des donnees d'entrainement a la surveillance post-deploiement.

Pourquoi les organisations devraient s'en preoccuper

Les systemes d'IA prennent desormais des decisions qui affectent la vie des gens : qui est embauche, qui obtient un pret, qui est libere sous caution, quels traitements medicaux sont recommandes. Lorsque ces systemes fonctionnent bien, ils ameliorent l'efficacite et l'equite. Lorsqu'ils echouent, les consequences peuvent etre devastatrices.

Prenons le biais. L'IA apprend a partir de donnees historiques, et si ces donnees refletent des discriminations passees, l'IA perpetue ces schemas. Nous avons vu des algorithmes de recrutement favoriser certaines categories demographiques, la reconnaissance faciale fonctionner mal sur les teintes de peau foncees, et des modeles de credit desavantager les communautes marginalisees. Ce ne sont pas des defauts techniques — ce sont des echecs ethiques qui enracinent les inegalites.

La transparence compte tout autant. De nombreux systemes d'IA fonctionnent comme des boites noires, prenant des decisions que leurs createurs ne peuvent pas pleinement expliquer. Si une IA refuse un emploi a quelqu'un ou le signale comme a haut risque, cette personne merite de comprendre pourquoi. Sans transparence, la responsabilite disparait et la confiance s'erode.

La vie privee et la securite sont egalement essentielles. Les systemes d'IA necessitent d'enormes quantites de donnees, incluant souvent des informations personnelles sensibles. Les organisations doivent proteger ces donnees et etre transparentes sur leur collecte et leur utilisation.

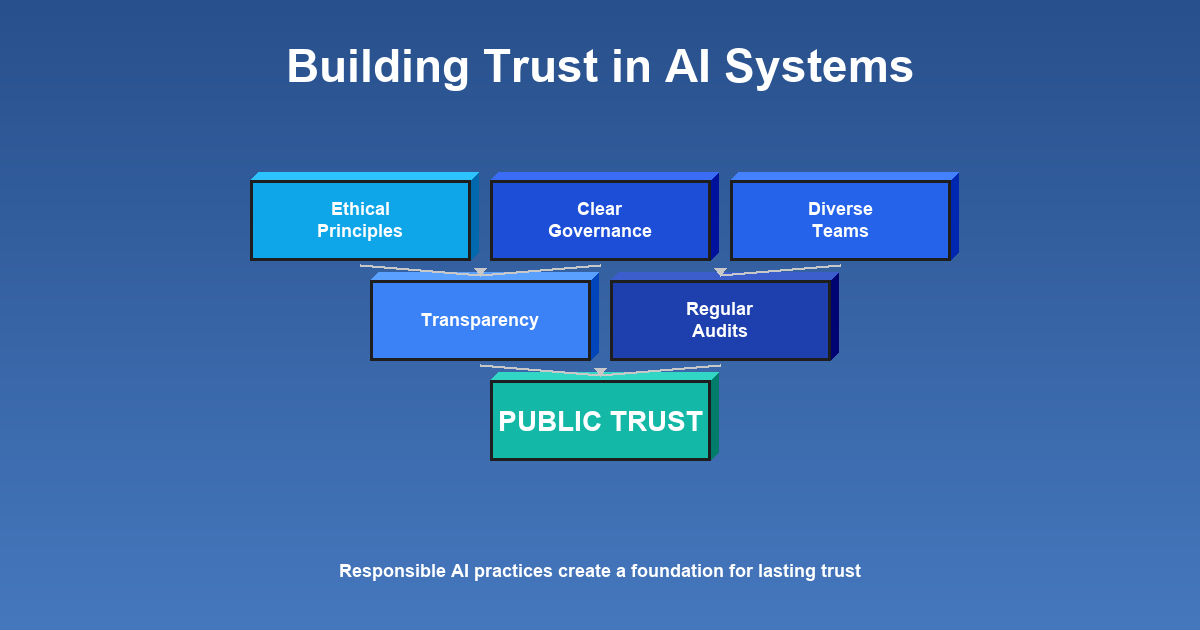

La confiance du public dans l'IA doit etre meritee. Lorsque les organisations prennent des raccourcis sur les pratiques responsables, elles risquent leur reputation et la volonte du public d'accepter l'IA de maniere generale. Construire la confiance exige une demonstration constante que les systemes servent les interets des personnes.

Le paysage reglementaire evolue rapidement. Les gouvernements du monde entier introduisent des reglementations sur l'IA. Les organisations qui n'ont pas priorise l'IA responsable pourraient se retrouver en difficulte pour se conformer. La responsabilite proactive est a la fois ethiquement saine et de plus en plus une exigence legale.

Construire une IA responsable : une approche pratique

Commencez par des principes ethiques clairs guidant chaque etape du developpement et du deploiement. Ceux-ci doivent etre specifiques a votre organisation mais incluent generalement des engagements en matiere d'equite, de transparence, de responsabilite, de confidentialite et de supervision humaine.

Creez un cadre de gouvernance definissant qui est responsable des decisions liees a l'IA, comment ces decisions sont prises et quels processus existent pour l'examen et l'audit. La gouvernance ne doit pas etre une simple case a cocher de conformite — elle doit etre integree dans la culture organisationnelle.

La diversite dans les equipes de developpement fait une vraie difference. Les equipes homogenes ont des angles morts concernant la maniere dont les systemes pourraient affecter differentes communautes. Des parcours et des perspectives varies aident a identifier les problemes tot et a concevoir des solutions qui fonctionnent pour tous.

Des audits reguliers detectent les problemes avant qu'ils ne causent des dommages. Testez les biais, evaluez les performances a travers les groupes demographiques et surveillez l'impact reel au fil du temps. Tester une seule fois au lancement ne suffit pas — une surveillance continue est essentielle car les systemes d'IA peuvent deriver en production.

Priorisez la transparence des le premier jour. Soyez ouvert sur ce que fait un systeme d'IA, quelles donnees il utilise et comment il prend ses decisions. Fournissez des explications pour les decisions pilotees par l'IA, en particulier lorsqu'elles affectent significativement les individus.

Investissez dans la formation pour que toutes les personnes impliquees — developpeurs, dirigeants, utilisateurs finaux — comprennent a la fois les capacites et les limites. L'IA responsable necessite l'adhesion a tous les niveaux.

Que se passe-t-il lorsque les organisations se trompent ?

Une IA mal concue perpetue et amplifie les biais existants. Des algorithmes ont discrimine les femmes dans le recrutement, donne des recommandations de peines plus severes pour les personnes de couleur et refuse des services aux populations agees. Ce ne sont pas des risques hypothetiques — ce sont des echecs documentes qui ont nui a de vraies personnes.

Lorsque les echecs deviennent publics, les dommages a la reputation peuvent etre immenses. La confiance, une fois perdue, est difficile a reconstruire. Les clients, partenaires et employes deviennent sceptiques quant a l'engagement ethique de l'organisation.

Les consequences juridiques sont de plus en plus probables. Les organisations deployant des systemes biaises ou nuisibles peuvent faire face a des poursuites, des sanctions reglementaires et des modifications obligatoires. Les regulateurs prennent des roles de plus en plus actifs pour tenir les organisations responsables.

Au-dela des prejudices directs, il y a un cout societal plus large. Chaque echec de l'IA alimente l'anxiete publique concernant ces technologies et rend plus difficile pour les organisations responsables de deployer l'IA de maniere benefique.

Les organisations qui negligent l'IA responsable passent egalement a cote d'opportunites de creer une veritable valeur. Une IA bien faite peut repondre aux defis pressants de la societe — mais seulement lorsqu'elle est construite sur la confiance et la responsabilite.

Leaders concrets de l'IA responsable

De nombreuses organisations donnent l'exemple. Microsoft a developpe un cadre complet de gouvernance de l'IA responsable avec des lignes directrices detaillees et des outils comme des listes de verification de l'equite. Ils ont rendu ces ressources publiquement disponibles, elevant le niveau dans toute l'industrie.

IBM a etabli un comite d'ethique de l'IA — un groupe dedie guidant les initiatives d'IA et assurant l'alignement avec les principes ethiques. Cette structure institutionnelle signale que l'IA responsable est une priorite aux plus hauts niveaux.

H&M a developpe son propre cadre d'IA responsable pour ses operations, de la gestion des stocks au service client, demontrant que l'IA responsable n'est pas reservee aux geants de la technologie.

Accenture a mis en place des outils de recrutement pilotes par l'IA concus pour reduire les biais de recrutement, avec des protections integrees et des audits reguliers. Cela montre comment les principes responsables peuvent etre operationnalises la ou les enjeux sont eleves.

Ces exemples partagent des themes communs : gouvernance proactive, transparence, surveillance continue et volonte d'etre tenu responsable.

Aller de l'avant

L'IA responsable est un voyage, pas une destination. A mesure que les technologies evoluent, notre comprehension de la responsabilite evoluera aussi. Ce qui compte, c'est l'engagement a questionner, ameliorer et se tenir responsable en permanence.

Ce n'est pas seulement un imperatif ethique — c'est strategique. Les organisations qui construisent la confiance par des pratiques responsables seront mieux positionnees pour innover, attirer les talents, se conformer aux reglementations et construire des relations durables.

Le potentiel de l'IA est reel, mais le realiser necessite de l'intentionnalite. En adoptant des pratiques responsables, les organisations contribuent a garantir que, a mesure que l'IA devient plus puissante, elle reflete nos valeurs les plus elevees.

La question n'est pas de savoir si nous aurons l'IA — nous l'avons deja. La question est de savoir quel type : une IA qui renforce les inegalites ou favorise l'equite ; une IA qui opere dans l'ombre ou qui est transparente ; une IA qui sert des interets etroits ou qui beneficie a la societe. Ces choix sont les notres.